摘要:,,本文介绍了爬虫技术在新浪财经实时数据领域的应用。文章详细解析了新浪财经实时数据爬虫技术的原理、方法和实现过程。通过爬虫技术,可以实时获取新浪财经的数据并进行深度分析,为投资者提供决策支持。文章旨在帮助读者了解并掌握实时数据爬虫技术的核心要点,以便更好地应用于实际场景中。

随着互联网技术的飞速发展,金融数据的重要性日益凸显,对于投资者而言,及时获取准确、全面的金融信息是提高投资成功率的关键,新浪财经作为权威的金融信息平台,其提供的实时数据倍受关注,本文将详细介绍如何利用爬虫技术从新浪财经爬取实时数据,帮助投资者更高效地进行投资决策。

爬虫技术概述

爬虫技术,即网络爬虫技术,是一种按照一定的规则自动抓取互联网数据的技术,通过模拟浏览器行为,爬虫能够获取网页内容并进行结构化处理,从而方便后续的数据分析和利用,在金融数据领域,爬虫技术能够帮助投资者快速获取大量的实时金融信息,提高投资效率和准确性。

新浪财经实时数据爬虫的实现步骤

1、确定数据源与目标

需要明确要爬取的新浪财经的数据源以及具体目标,可能是某个股票的价格信息、新闻动态或者是整个财经板块的实时数据等,这有助于后续制定详细的爬虫策略。

2、数据抓取策略制定

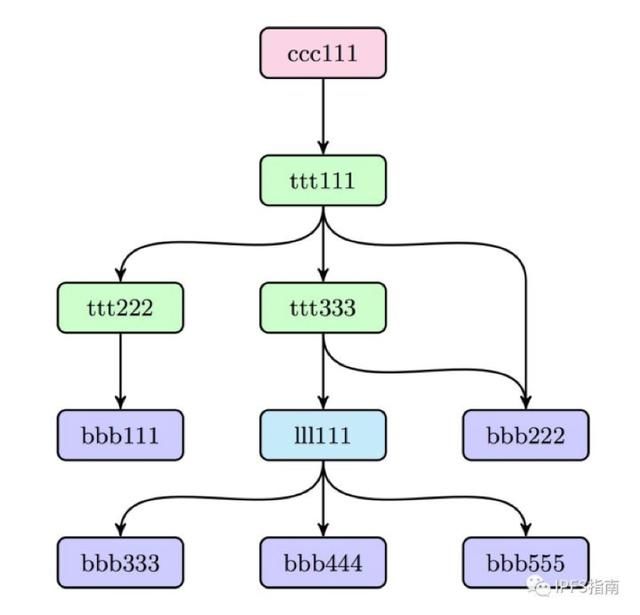

针对目标数据源,需要制定合适的数据抓取策略,这包括选择适当的爬虫框架(如Scrapy、BeautifulSoup等),确定抓取频率(避免过于频繁的请求导致IP被封),以及处理反爬虫机制等。

3、模拟浏览器行为

由于新浪财经页面可能采用JavaScript动态加载数据,直接请求可能无法获取到真实数据,需要使用爬虫模拟浏览器行为,如设置合适的User-Agent、Cookies等,以便成功获取数据。

4、数据解析与提取

获取网页内容后,需要利用数据解析技术(如正则表达式、XPath等)从HTML中提取目标数据,对于新浪财经这样的动态页面,可能需要结合Selenium等工具进行页面元素的定位和数据的提取。

5、数据存储与处理

提取的数据需要进行存储和处理,以便于后续的分析和使用,可以选择将数据存入数据库(如MySQL、MongoDB等),或者进行进一步的数据清洗、转换等操作。

技术难点与解决方案

1、动态加载数据的处理

新浪财经等金融网站常常采用动态加载数据的方式,直接获取到的页面源码中不包含真实数据,解决方案是使用Selenium等工具模拟浏览器操作,等待页面完全加载后再进行数据的提取。

2、反爬虫机制的处理

金融网站通常会有反爬虫机制来防止恶意爬取,对此,可以通过设置合理的请求头、使用代理IP、合理安排请求时间间隔等方式来应对。

3、数据格式的标准化处理

由于网页结构可能随时发生变化,爬取到的数据格式可能不稳定,需要对数据进行标准化处理,确保数据的准确性和一致性。

法律风险与合规建议

在爬取新浪财经实时数据时,必须遵守相关法律法规和网站的使用协议,避免侵犯版权和隐私等问题,建议事先了解相关法律法规,并在合法合规的前提下进行爬取操作。

通过本文的介绍,我们详细了解了如何利用爬虫技术从新浪财经爬取实时数据,随着金融市场的不断变化和技术的不断进步,未来的爬虫技术将更趋于智能化和自动化,投资者应关注技术发展,合理利用爬虫工具,提高投资效率和准确性,也需要注意法律风险,确保合规操作。

转载请注明来自醉美玉溪,本文标题:《新浪财经实时数据爬虫技术深度解析与实战指南》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...